できることと用途

- 画像生成時にポーズや構造をコントロールするためのStable Diffusion拡張機能。

- 既存画像を元に再生成したり、線画から着彩したりと多彩な使い方が可能。

- OpenPose、Depth、Cannyなどの「プリプロセッサ」と、対応する「モデル」を組み合わせて使う。

同じ環境のPCで1024×1024の画像生成にかかる時間が約3分から約30秒に短縮してました。安定性やStable-Diffusionとの違いを覚えるのが大変ですが、ぜひ導入したいところだと思います。

ステーブルディフュージョン(Stable Diffusion)できれいな画像を効率よく作成するための情報を紹介しているブログをいくつかご紹介します。以下に、それぞれのブログの主要なポイントをまとめます。

1. 菊学ブログ:Stable Diffusion拡張機能の活用

このブログでは、Stable Diffusionの拡張機能を使って画像生成の効率を上げる方法を紹介しています。主な内容は:

- ControlNet:既存の画像を元に新しい画像を生成する機能

- Latent Couple:複数の画像を組み合わせて新しい画像を作成する機能

- Depth to Image:深度マップを使って3D的な画像を生成する機能

これらの拡張機能を使うことで、より細かい制御や複雑な画像生成が可能になります。

2. ひかりAIアート:基本的なコツと呪文一覧

このブログでは、Stable Diffusionで画像を生成する際の基本的なコツを3つ紹介しています:

- プロンプトの書き方:細かい指示を含めることで、より意図した画像を生成できる

- ネガティブプロンプト:不要な要素を除外することで、クオリティを上げられる

- サンプリング方法とステップ数:適切な設定で画質と生成速度のバランスを取る

また、効果的な呪文(プロンプト)の一覧も提供されており、これらを参考にすることで効率的に質の高い画像を生成できます。

3. EdgeHUB:プロンプトのコツ

このブログでは、Stable Diffusionのプロンプト作成に関する詳細なコツを紹介しています:

- キーワードの順序:重要な要素から順に記述する

- 詳細な指定:画像の構図、スタイル、色彩などを細かく指定する

- アーティスト名の活用:特定のアーティストのスタイルを参考にする

- 重みづけ:括弧を使って特定のキーワードの重要度を調整する

これらのテクニックを組み合わせることで、より意図に沿った高品質な画像を効率的に生成することができます。

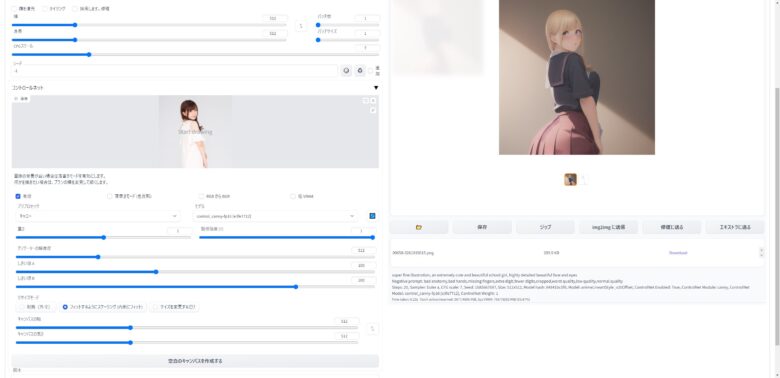

ControlNetの基本設定と導入手順

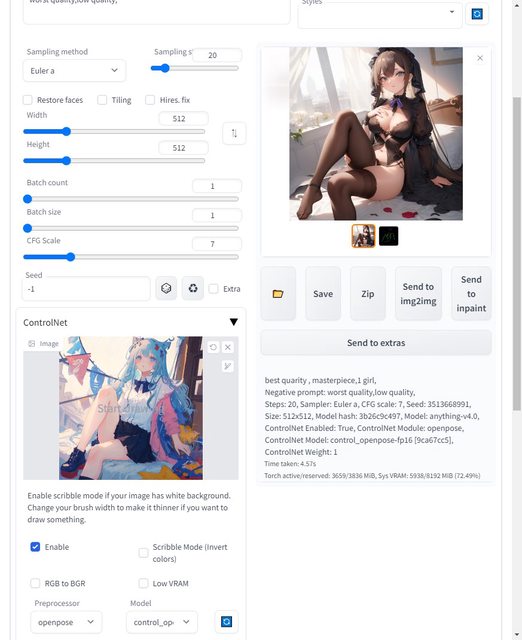

ControlNetはControlNetの欄に下のような元画像を用意して、

- Promptをいれて

- プリプロセッサを入れ、

- モデルを指定して

- 生成する

ことで、ポーズを指定した画像が生成できる。

このようにほぼ同じポーズのイラストが生成されます。

プリプロセッサとモデルは、よくわからないならcannyでOK(?

PCで自前生成した画像は保存する必要ないです

※生成した画像はStableDiffusionのoutputフォルダに保存されてるので、自分で保存する必要はなし

むしろ、生成失敗したのは定期的に消さないとSSDがやばい。

主要機能の使い方3パターン

絵柄については、安定拡散チェックポイントで指定したモデル?で、決まる模様。

どんな絵が出力されるかは、PromptとBad Promptの内容もかなり影響する。

背景指定は、simple_Backgroundが無難っぽい?

White_Background とか、Green_Background など、色を指定すると白髪になったり、服が緑になるなどもよくある💦

Controle-netの使い方

Controle-netの使い方で、よく使われそうな機能は次の3つ

- 棒人間でポーズを指定して画像を生成 (open pose / editor)

- 画像からポーズを割り出して画像を生成

- 線画抽出して着彩した画像を生成 (canny)

OpenPoseでポーズを指定して画像生成

ControlNetを使うと生成するキャラのポーズを厳密に指定することができるが、

無料の拡張機能「Openpose Editor」をつかえば、絵を用意しなくてもポーズが指定できる

導入については、

くろくまそふとさんを参照

当方の環境だと、

- txt2imgに送る

- img2imgに送る

を押しても機能しないので、pngを保存してコントロールネットの画像指定枠に放り込めば使えるようになる。

使ったところの様子はこんな感じ

- Openpose Editorでモデルにポーズをとらせる

- pngを保存

- コントロールネットの画像枠にpngをドラッグドロップ

- Prompt、バッドプロンプトを指定

- プリプロセッサを 「なし(none)」

- モデルを「Open pose16・・」などの、OpenPoseを使えるモデルに変更

- 生成する

という手順になる

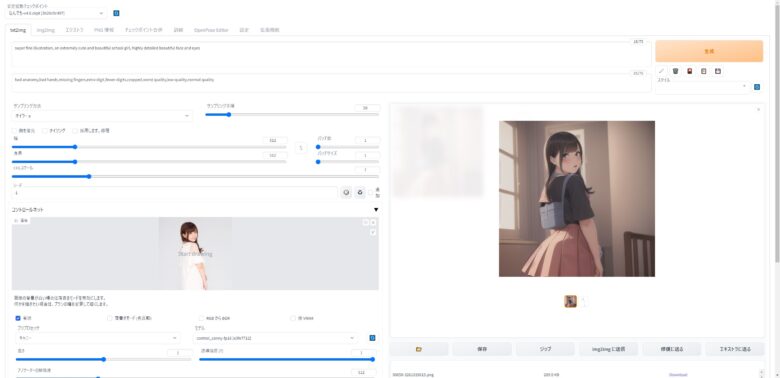

画像からポーズを抽出して再生成

- コントロールネットの画像枠にベースとなる画像をドラッグドロップ

- Prompt、バッドプロンプトを指定

- プリプロセッサを 「open pose」

- モデルを「Open pose16・・」などの、OpenPoseを使えるモデルに変更

- 生成する

画像からポーズを判定して、画像を生成してくれる。

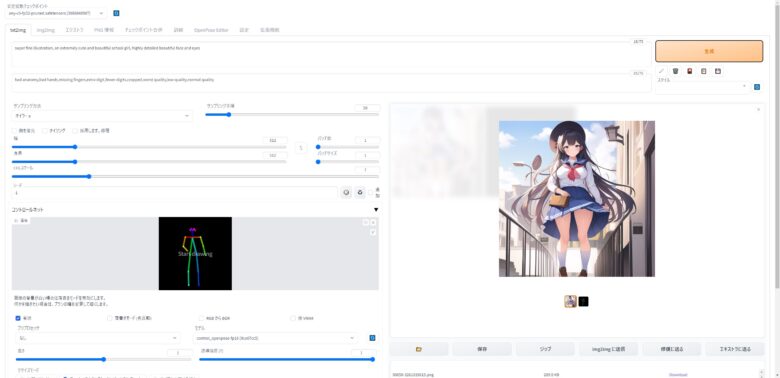

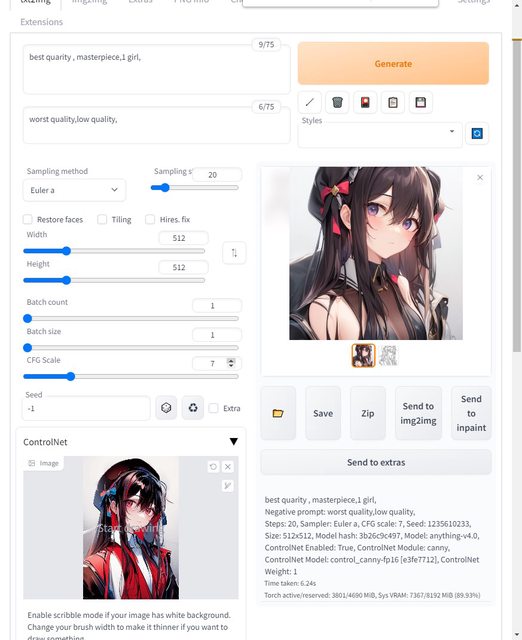

線画抽出+自動着彩(Canny)

- コントロールネットの画像枠にpngをドラッグドロップ

- Prompt、バッドプロンプトを指定

- プリプロセッサを 「canny」

- モデルを「canny」モデルに変更

- 生成する

線画を抽出して着彩してくれる

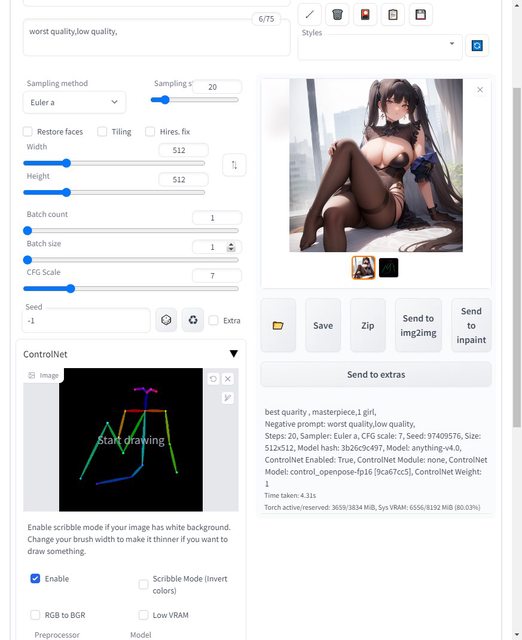

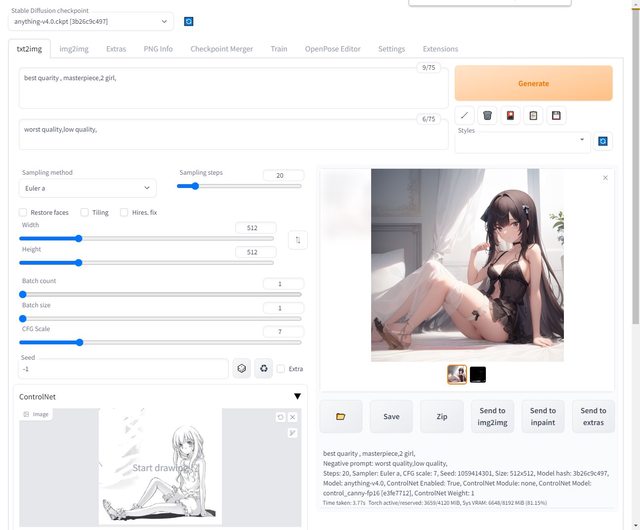

自分の描いた画像をベースに色を塗った画像を生成してもらう

用紙色:白に黒の線で描いたイラストをベースに色を塗ってもらいます。

着彩できるのは、原則として一人だけです。

また、線画は選択したモデルをベースに再生成されるので、描いた線画に忠実に色を塗ってくれるわけではないようです。

- コントロールネットの画像枠にpngをドラッグドロップ

- Prompt、バッドプロンプトを指定

- プリプロセッサを 「none」

- モデルを「canny」モデルに変更

- scribble mode(invert color)にチェックを入れる (用紙色=黒に白で絵を描けば不要)

- 生成する

線画からポーズを抽出して画像を生成して着彩してくれます。

プロンプトと背景設定の注意点

- 背景指定で生成画像に影響(例:「White_Background」で髪や服が変色)。

simple_backgroundなどの無難な表現がおすすめ。- PromptとBad Promptの調整が品質に大きく影響。

生成画像の保存場所と整理のコツ

- Web UIでは自動で

outputsフォルダに保存。 - 失敗画像も保存されるため、定期的な削除でSSDの容量対策を。

よくあるトラブルと解決法

- プリプロセッサやモデルの不一致 → 設定を再確認。

- ControlNet画像が認識されない → 形式・パス・再起動を確認。

- 保存されない・反映されない → outputディレクトリ or 設定ミスを確認。

まとめ:ControlNetを使いこなすコツ

- 基本は Prompt + ControlNet画像 + モデル + プリプロセッサの組み合わせ。

- 初心者はまず「OpenPose」または「Canny」から始めるのが◎。

- モデルや画像の扱いに慣れると、高度なイラスト制御が誰でも可能に!

補足リンク(任意)

- ControlNet 公式GitHub → https://github.com/lllyasviel/ControlNet

コメント